Die Herausforderungen in Gesundheitsversorgung sind vielfältig. Neben politischen und finanziellen Herausforderungen stehen etliche Schwierigkeiten, die durch Engpass an Personal entstehen. Dieser Engpass führt oft zum Kompromiss, dass das medizinische Personal längere Schichten absolviert als initial geplant. Schon während des Studiums wird Medizinstudierenden klar, dass die Praxis von Gesundheitsversorgung nicht immer nur durch Medizin und Forschung bestimmt wird, sondern auch viel von organisatorischen Prozessen.

Die gängigen organisatorischen Prozesse könnten sein z.B. für Assistenzärzte Dokumentation in Form von Arztbriefen, für Fachärzte Abrechnung in Form von OPS-Kodierung, für MFA oder gar ärztliches Personal die Aufsuchung vom Betreuungsplatz in einer sozialen Einrichtung für multimorbiden Patienten.

In meiner beruflichen Laufbahn als Medizinstudent und später leitender Architekt von großen GenAI-Projekten ist mir häufig aufgefallen, dass es in Klinikalltag sich wiederholende Aufgaben gibt, deren Automatiserung zu erheblichen Aufwandreduktion führen würde. Solche Aufwandreduktion könnte man primär in finanziellen Metriken messen aber auch gibt es eine soziale Kompetenz, wie z.B. Zufriedenheit vom ärztlichen Personal, sich mehr Medizin widmen zu dürfen.

In diesem Artikel möchte ich mich an das Thema OPS-Kodierung mittels Large-Language-Models (LLM) widmen. Der Operationen- und Prozedurenschlüssel (OPS) ist die amtliche Klassifikation zum Verschlüsseln von Operationen, Prozeduren und allgemein medizinischen Maßnahmen. Mehr über OPS kann man hier nachlesen. Bereits mit Cody (Demo-Version hier verfügbar) haben wir zeigen können, dass das richtige Auffinden und Kodieren von anerkannten Therapieansätzen einfach und schnell gehen kann. Nun geht es darum, so ein Verfahren auf Edge-Geräten zu bringen, um eventuell solche Kodierung direkt am Gerät wie Smartphone durchzuführen.

Architektur

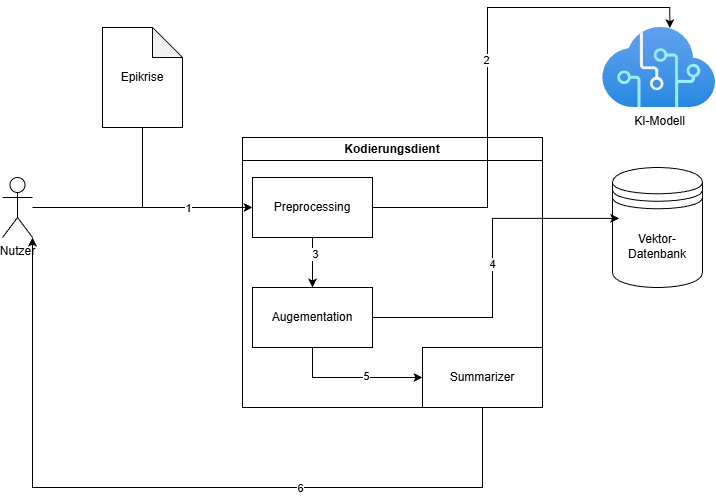

- Der Anwender liefert dem Kodierungsdienst die Anweisung bei Patient X zu einem bestimmten Krankenhausaufenthalt die Kodierung vorzunehmen. Da dieser Schritt vom Krankenhausinformationssystem stark abhängt, könnte das bei verschiedenen Systemen stark unterscheiden.

- In Pre-Processing-Schritt werden aus Epikrise therapierelevante Informationen extrahiert. Dies geschieht durch einem LLM, welches basiert auf Trainingsdaten und Anweisungen gezielt Informationen filtert, transformiert und zusammenfasst.

- Diese Liste an möglichen Codes wird zunächst an Augmentationsalgorithmus weitergegeben.

- Nun werden aus der Liste an relevanten OPS-Codes die richtigen Codes mittels Nearest-Neighbour-Algorithmus herausgesucht. Das geschieht hochperformant mithilfe einer Vektor-Datenbank, welche für solche Anfragen spezialisert ist. So eine Datenbank aufzubauen ist schwer. Daher habe ich hier die nötigen Tabellen zum Scrapen bereitgestellt ♥️

- In diesem Schritt liegen dem System alle Informationen vor. Das System gestaltet die Ausgaben dann an das vom Anwender erwünschte Format.

- Die Ausgabe wird an Anwender gemacht.

Analyse aus Produktion

Aus unseren Daten aus der Produktion der Cody Demo hat Cody uns gezeigt, dass die allgemeine Bereitschaft sehr hoch war, so eine technologie im Alltag zu benutzen. Insgesamt haben wir im Zeitraum von 3 Monaten im Schnitt 22 Kodierungen/Tag verzeichnet. Die Zahl an sich mag nicht allzuhoch scheinen, aber im Demo-Pool von ca. 4 Krankenhäusern in dieser Instanz waren ca 20 Leute für die Demo freigeschaltet. Allerdings waren in der Eingabe nicht immer vollständige Epikrisen sondern auch kürzere Fallbeispiele. Diese wurden in der nachfolgenden Analyse nicht berücksichtigt.

OPS-Codes

Im Durchschnitt aus dem obigen Diagramm sieht man, dass in einer vollständigen Epikrise (>200 Wörter)[n=107] ca. 14 OPS-Codes erkannt wurden, wovon 12 mit Vektor-Matching (aus der DB + Evaluationsalgorithmus, unten erläutert) als richtig erkannt wurden. Von 14 waren die anderen 2 entweder schon erkannt worden oder fehlerhaft erkannt.

Response Time

Bei den Anfragen hat es im Schnitt ca. 12 Sekunden gedauert, um aus Epikrise mit großer Wörteranzahl die OPS-Codes zurückzugeben.

Schwierigkeiten

LLM-Limits

In der Nutzung von solchen KI-Anwendungen gibt es verschiedene Schwierigkeiten, die grundsätzlich vom LLM selbst stammen. Z.B. Datenschutz ist in Klinikkontext wohl das Relevanteste, da meistens die Kliniken kaum Infrastruktur haben, KI-Modelle selbst für Inferenz zu betreiben. Daher bleibt die Option, große Cloud-Provider zu nutzen. Hier sind die Option in der Hinsicht aber auch nicht unbedingt schlecht. V.a. Optionen wie Hugginface API, Azure OpenAI, Nvidia Cloud bieten gute Startmöglichkeiten. Hier wäre aber auch erwähnenswert, dass bei Nutzung externer Betreiber eine PII-Redaktion von immenser Wichtigkeit ist.

Außerdem kommt es immer wieder zu LLM-Content Moderation, weil zum Teil medizinische Texte durch Sicherheitsmechanismen falsch-positiv als anstößig oder sogar als Körperverletzung erkannt werden. Das hängt sehr vom LLM ab und erfordert meist Prompt Tuning.

Token/Rate Limits sind zwar immer weniger das Problem aber je nach Betrieber und Nutzeranzahl auch wichtig für Nutzerzufriedenheit.

Evaluation der Ergebnisse

Da OPS-Kodierung mit der Bepreisung der Therapie die wichtigste Säule in Finanzierbarkeit der Gesundheitsversorgung darstellt, sind Fehler umso inakzeptabler. Fehler in solch einem System kann unter Umständen große finanzielle Nachteile darstellen. Bei Umsetzung solcher Projekte ist mir aufgefallen: Klassische Test-Strategien sind schwer umzusetzen. Daher habe ich Algorithmen entwickelt, die Ausgaben von KI-Systemen in Echtzeit überwachen können.

Kurzgefasst: Die Algorithmen können entweder auch Näherungs- oder unabhängigen LLM-Backends können den Therapieansatz und den Erklärungstext zu OPS-Code überprüfen und ablehnen. Somit kann eine falsche Ausgabe vermieden werden.

Vorteile

Standards

Durch LLM-Einsatz in OPS-Kodierung können verschiedene Prozesse beschleunigt werden. Zum Einen sehe ich großes Potenzial darin, schnell durch KI Codes zu erzeugen, die sowohl krankehausseitig als auch krankenkassenseitig den Überprüfungsaufwand enorm reduzieren kann. V.a. wäre das eine große Chance, einen maschienengeeigneten Übermittlungsstandard zu schaffen, welcher in Zukunft Re-Training eines selbst-gehosteten LLMs ermöglicht und das LLM immer besser für diesen Use-Case macht.

Plattform

Auf der anderen Seite, ein solcher LLM-Agent schafft Plattform für Einsatz anderer Agenten, welche ebenso andere Prozesse übernehmen können. So wird ein digitales Krankenhaus ein Suite an KI-Agenten leichter betrieben können und organisatorischen Aufwand durch Mixture-of-Agents erheblich reduzieren.

Zusammenfassung

Ein KI-Prozess für Automatisierung organisatorischen Prozesses kann in einem Krankenhaus erheblich Personal- und Zeitaufwand reduzieren. Ein solches System wird mit immer besser werdenden LLMs immer genauer. Mittels Evaluationsalgorithmen kann eine hohe Genauigkeit und Fehleridentifikation rechtzeitig sichergestellt werden. Eine selbstbetriebene Infrastruktur kann Plattform für digitales Krankkenhausbieten und LLM-Anwendungen den Weg bereiten.

Ich bedanke mich, dass ihr euch Zeit genommen habt, diesen Blogpost zu lesen. Bei Fragen und Anregungen bin ich jederzeit per Email an bijay@regmi.dev erreichbar.

Falls du über neuste Blogposts von mir benachrichtigt werden willst, bitte trage in das Formular deine Email-Adresse ein.

Anwendung von LLMs im Klinikalltag